Ubuntn 應用程式安裝

► SSH & rsync

from https://hadoop.apache.org/docs/r1.2.1/single_node_setup.html#Installing+...

► SSH & rsync

1. 安裝

sudo apt-get install ssh (hadoop內部許多核心透過此協定進行通訊, 因此必須安裝否則資訊顯示不齊全)

sudo apt-get install rsync (利用rsync將資料同步)

登入測試 ssh localhost

sudo apt-get install rsync (利用rsync將資料同步)

登入測試 ssh localhost

2. 製作不需密碼即可透過 ssh 登入方式, 主要在開發測試中省去輸入作業

ssh-keygen -t dsa -P '' -f ~/.ssh/id_dsa

cat ~/.ssh/id_dsa.pub >> ~/.ssh/authorized_keys

► Java SDK 參考說明

cat ~/.ssh/id_dsa.pub >> ~/.ssh/authorized_keys

1. JSDK 下載 Java SE Development Kit 7 Downloads jdk-7u45-linux-i586.tar.gz. x86或x64 則依系統選擇

2. 解壓縮 tar -xvf jdk-7u45-linux-i586.tar.gz 通常產生一個 jdk1.7.0_45 對應版本的目錄

3. 接著將整個 jdk 目錄移動到 /usr/lib 目錄內

2. 解壓縮 tar -xvf jdk-7u45-linux-i586.tar.gz 通常產生一個 jdk1.7.0_45 對應版本的目錄

3. 接著將整個 jdk 目錄移動到 /usr/lib 目錄內

sudo mkdir -p /usr/lib/jvm

sudo mv ./jdk1.7.0_45 /usr/lib/jvm/jsdk

sudo mv ./jdk1.7.0_45 /usr/lib/jvm/jsdk

4. 執行 JSDK 安裝

sudo update-alternatives --install "/usr/bin/java" "java" "/usr/lib/jvm/jsdk/bin/java" 1

sudo update-alternatives --install "/usr/bin/javac" "javac" "/usr/lib/jvm/jsdk/bin/javac" 1

sudo update-alternatives --install "/usr/bin/javaws" "javaws" "/usr/lib/jvm/jsdk/bin/javaws" 1

sudo update-alternatives --install "/usr/bin/javac" "javac" "/usr/lib/jvm/jsdk/bin/javac" 1

sudo update-alternatives --install "/usr/bin/javaws" "javaws" "/usr/lib/jvm/jsdk/bin/javaws" 1

5. 設定權限

sudo chmod a+x /usr/bin/java

sudo chmod a+x /usr/bin/javac

sudo chmod a+x /usr/bin/javaws

sudo chown -R root:root /usr/lib/jvm/jsdk

sudo chmod a+x /usr/bin/javac

sudo chmod a+x /usr/bin/javaws

sudo chown -R root:root /usr/lib/jvm/jsdk

6. 設定環境變數

建立 sudo gedit /etc/profile.d/forJava.sh(名稱自取) 內容如下

export JAVA_HOME=/usr/lib/jvm/jsdk

export JRE_HOME=$JAVA_HOME/jre

export CLASSPATH=.:$JAVA_HOME/lib:$JRE_HOME/lib:$CLASSPATH

export PATH=$JAVA_HOME/bin:$JRE_HOME/bin:$PATH

export JAVA_HOME=/usr/lib/jvm/jsdk

export JRE_HOME=$JAVA_HOME/jre

export CLASSPATH=.:$JAVA_HOME/lib:$JRE_HOME/lib:$CLASSPATH

export PATH=$JAVA_HOME/bin:$JRE_HOME/bin:$PATH

7. 測試 java -version

► 安裝 Hadoop

1. 下載 Hadoop hadoop-1.2.1.tar.gz

2. 解壓縮 tar -xvf hadoop-1.2.1.tar.gz 通常產生一個 hadoop-1.2.1 對應版本的目錄

3. 將資料夾移動到 /opt 下, sudo mv hadoop-1.2.1 /opt/hadoop

4. 進入 /opt/hadoop/conf 目錄

2. 解壓縮 tar -xvf hadoop-1.2.1.tar.gz 通常產生一個 hadoop-1.2.1 對應版本的目錄

3. 將資料夾移動到 /opt 下, sudo mv hadoop-1.2.1 /opt/hadoop

4. 進入 /opt/hadoop/conf 目錄

編輯 hadoop-env.sh , sudo gedit hadoop-env.sh 設定下參數

export JAVA_HOME=/usr/lib/jvm/jsdk

export HADOOP_HOME=/opt/hadoop

export PATH=$PATH:/opt/hadoop/bin

export HADOOP_HOME=/opt/hadoop

export PATH=$PATH:/opt/hadoop/bin

編輯 core-site.xml

<configuration>

<property>

<name>fs.default.name</name>

<value>hdfs://localhost:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/tmp/hadoop/hadoop-${user.name}</value>

</property>

</configuration>

<property>

<name>fs.default.name</name>

<value>hdfs://localhost:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/tmp/hadoop/hadoop-${user.name}</value>

</property>

</configuration>

編輯 hdfs-site.xml

<configuration>

<property>

<name>dfs.name.dir</name>

<value>/opt/hadoop/datalog1</value>

</property>

<property>

<name>dfs.data.dir</name>

<value>/opt/hadoop/data1</value>

</property>

// data node 寫資料到 local disk 上的權限,若不一致將無法啟動,default=700

<!-- <property>

<name>dfs.datanode.data.dir.perm</name>

<value>700</value>

</property> -->

<property>

<name>dfs.replication</name>

<value>1</value> //單機模式需為 1

</property>

</configuration>

<property>

<name>dfs.name.dir</name>

<value>/opt/hadoop/datalog1</value>

</property>

<property>

<name>dfs.data.dir</name>

<value>/opt/hadoop/data1</value>

</property>

// data node 寫資料到 local disk 上的權限,若不一致將無法啟動,default=700

<!-- <property>

<name>dfs.datanode.data.dir.perm</name>

<value>700</value>

</property> -->

<property>

<name>dfs.replication</name>

<value>1</value> //單機模式需為 1

</property>

</configuration>

編輯 mapred-site.xml

<configuration>

<property>

<name>mapred.job.tracker</name>

<value>localhost:9001</value>

</property>

</configuration>

<property>

<name>mapred.job.tracker</name>

<value>localhost:9001</value>

</property>

</configuration>

編輯 masters, slaves 檔

若為單機僅需建立 localhost, 若多機鑿再加入其他主機名稱

5. 啟動

a. source /opt/hadoop/conf/hadoop-env.sh

b. 第一次運作前需格式化 /opt/hadoop/bin/hadoop namenode -format

c. /opt/hadoop/bin/start-all.sh

b. 第一次運作前需格式化 /opt/hadoop/bin/hadoop namenode -format

c. /opt/hadoop/bin/start-all.sh

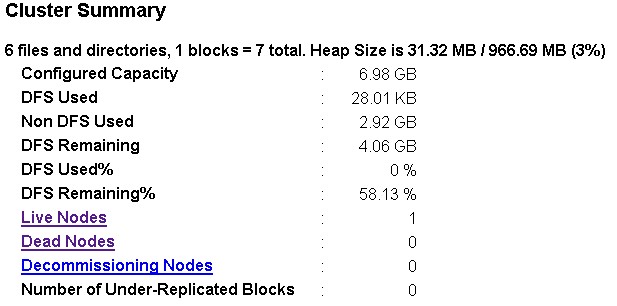

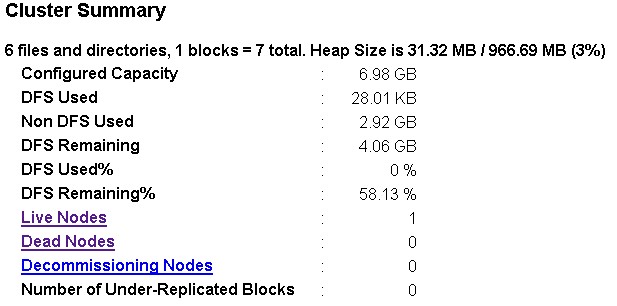

6. 測試 查看NameNode http://localhost:50070 (初始約1分鐘內需看見Live Nodes數據才正確, 不然通常是 DataNode 啟動有問題, 可查看log了解原因), 查看 JobTracker http://localhost:50030

若系統處於 Safe mode On下, 久未Off , 則可下命令 hadoop dfsadmin -safemode leave 解除. 否則系統將處於唯讀狀態.(說明)

7. 停止 /opt/hadoop/bin/stop-all.sh

► Eclipse 安裝

1. 下載 Eclipse (我使用indigo版 eclipse-java-indigo-SR2-linux-gtk.tar.gz)

2. 解壓縮 tar -xvf eclipse-java-indigo-SR2-linux-gtk.tar.gz 通常產生一個 eclipse 對應版本的目錄

3. 將資料夾移動到 /opt 下, sudo mv eclipse /opt/eclipse

4. 建立 sudo gedit /usr/share/applications/eclipse.desktop 內容如下

2. 解壓縮 tar -xvf eclipse-java-indigo-SR2-linux-gtk.tar.gz 通常產生一個 eclipse 對應版本的目錄

3. 將資料夾移動到 /opt 下, sudo mv eclipse /opt/eclipse

4. 建立 sudo gedit /usr/share/applications/eclipse.desktop 內容如下

[Desktop Entry]

Type=Application

Name=Eclipse

Comment=Eclipse Integrated Development Environment

Icon=/opt/eclipse/icon.xpm

Exec=/opt/eclipse/eclipse

Terminal=false

NoDisplay=false

Categories=Development;IDE;Java;

Type=Application

Name=Eclipse

Comment=Eclipse Integrated Development Environment

Icon=/opt/eclipse/icon.xpm

Exec=/opt/eclipse/eclipse

Terminal=false

NoDisplay=false

Categories=Development;IDE;Java;

5. 接著就可將該 程序 移動到 Xwindows 啟動列了

6. hadoop 開發環境安裝

6. hadoop 開發環境安裝

from https://hadoop.apache.org/docs/r1.2.1/single_node_setup.html#Installing+...